注意

本文档适用于 Ceph 开发版本。

Ceph NVMe-oF 网关

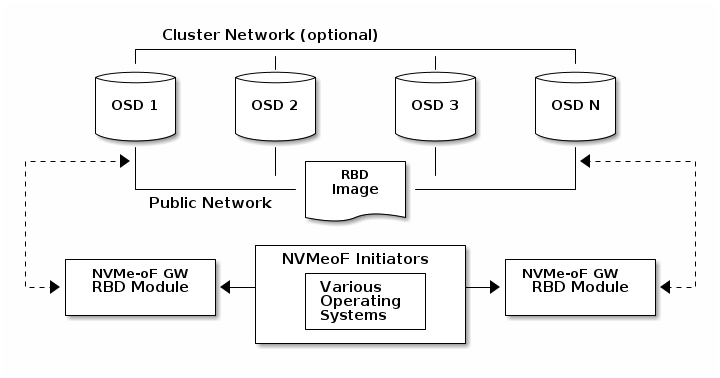

存储管理员可以为存储Ceph集群安装和配置NVMe over Fabrics (NVMe-oF)网关。使用Ceph NVMe-oF网关,您可以有效地运行一个完全集成的块存储基础设施,具有传统存储区域网络(SAN)的所有功能和优势。

NVMe-oF网关将存储Ceph与NVMe over TCP (NVMe/TCP)协议集成,以提供导出RADOS Block Device (RBD)镜像的NVMe/TCP目标。NVMe/TCP协议允许客户端(称为发起者)通过互联网协议网络向存储设备(称为目标)发送NVMe-oF命令。发起者可以是Linux客户端、VMware客户端或两者。对于VMware客户端,NVMe/TCP卷显示为VMFS数据存储,对于Linux客户端,NVMe/TCP卷显示为块设备。

使用 NVMe-oF 网关组实现高可用性

高可用性(HA)为主机发起者提供I/O和控制路径冗余。高可用性有时也被称为故障转移和故障恢复支持。HA创建的冗余对于防止一个或多个网关故障至关重要。通过HA,主机可以在仅有可能出现性能延迟的情况下继续I/O,直到故障网关恢复并正常运行。

NVMe-oF网关在逻辑上分组为网关组,HA域位于网关组内。当前的NVMe-oF网关组支持八个网关。网关组中的每个NVMe-oF网关都可以用作该网关组中定义的任何子系统或命名空间的路径。在网关组中有两个或更多网关时,HA是有效的。

高可用性默认启用。要使用高可用性,必须在每个GW上为子系统定义至少两个网关和监听器。

在主机和网关之间创建冗余非常重要。要创建完全冗余的网络连接,请确保主机具有两个以太网端口,这些端口通过具有冗余的网络连接到网关(例如,两个网络交换机)。

HA功能对每个命名空间使用Active/Standby方法。使用Active/Standby意味着在任何时候,组中的NVMe-oF网关中只有一个为从主机到特定命名空间提供服务。为了正确使用所有NVMe-oF网关,每个命名空间分配给不同的负载均衡组。负载均衡组的数量等于网关组中NVMe-oF网关的数量。

如果组中的一个或多个GW死亡或无法被Ceph NVMe-oF监控器看到,将触发自动故障转移,组中的另一个GW将承担故障GW(s)的负载均衡组的责任。这意味着没有对IO造成中断,因为另一个GW将继续为这些命名空间提供服务。如果故障的GW(s)再次出现,将自动触发故障恢复。

主机上的NVMe-oF发起者也将继续尝试连接故障GW,时间为在connect-all命令中指定的连接时间。推荐的时间是1800秒。

使用 NVMe-oF 网关进行扩展

NVMe-oF网关支持水平扩展。NVMe-oF网关水平扩展支持:

NVMe-oF 网关发现

Ceph NVMe-oF网关支持发现。在Ceph集群中运行的每个NVMe-oF网关也运行一个发现控制器。发现控制器报告GW组中的所有子系统。

由 Ceph 基金会带给您

Ceph 文档是一个社区资源,由非盈利的 Ceph 基金会资助和托管Ceph Foundation. 如果您想支持这一点和我们的其他工作,请考虑加入现在加入.