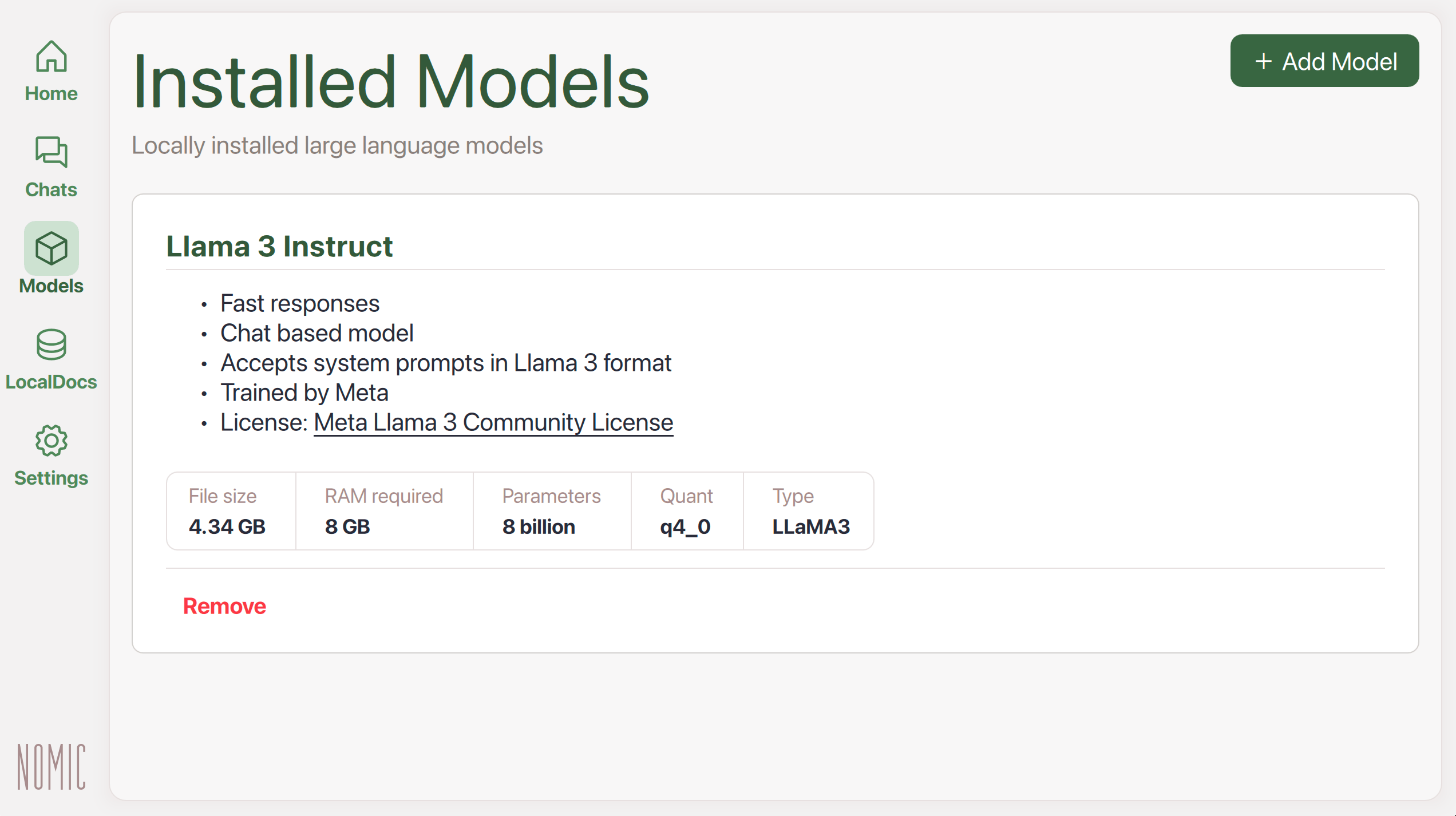

模型

GPT4All针对在消费级硬件上运行3-13B参数范围的LLM进行了优化。

LLM被下载到您的设备上,以便您可以在本地和私密地运行它们。通过我们的后端,任何人都可以在其硬件上高效且安全地与LLM进行交互。

下载模型

下载模型

| 1. | 点击Models在左侧菜单中(下方Chats和上方LocalDocs) |

|

| 2. | 点击+ Add Model导航到Explore Models页面 |

|

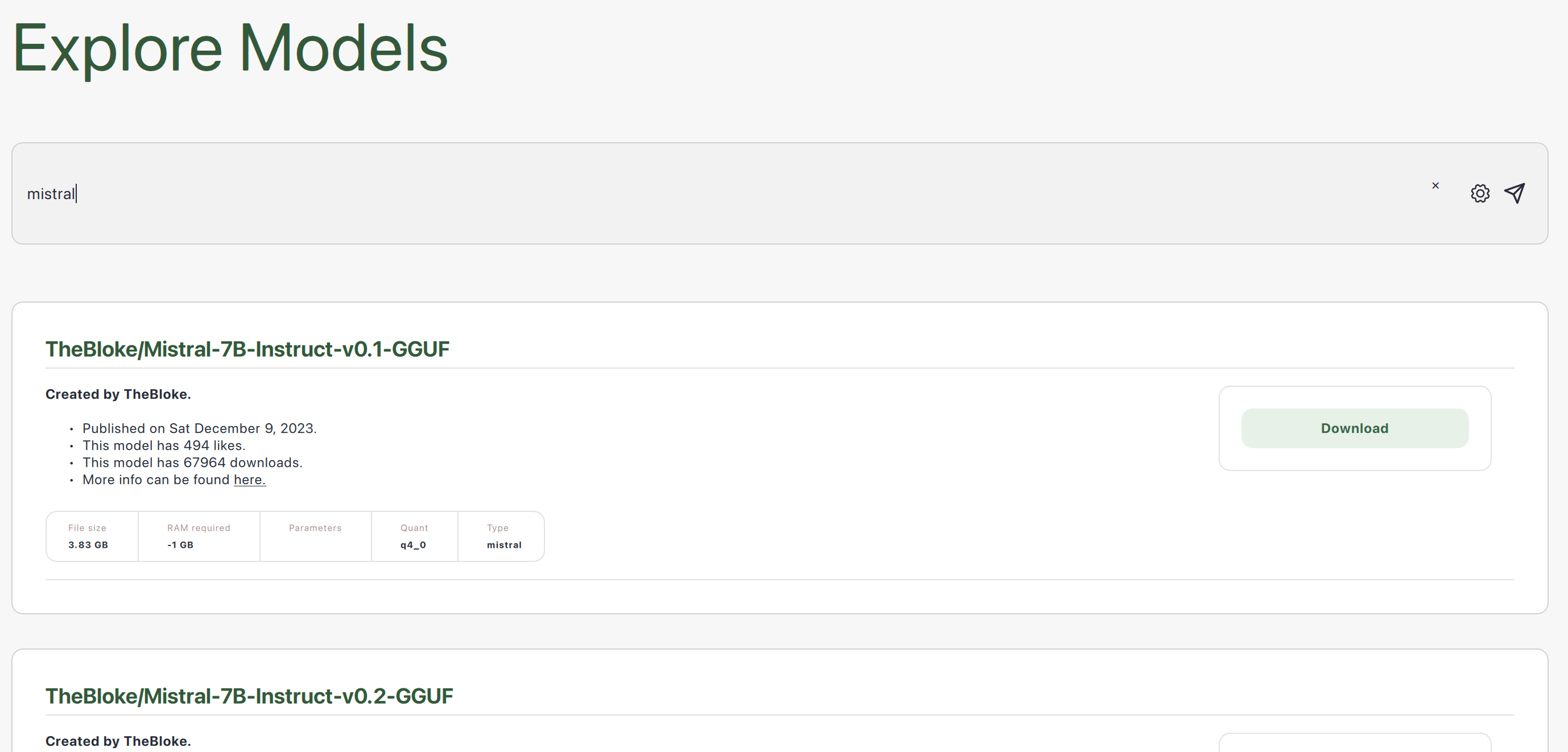

| 3. | 搜索在线可用的模型 |  |

| 4. | 点击Download保存模型到您的设备 |

|

| 5. | 下载模型后,您将在中看到它Models. |

|

探索模型

GPT4All通过一个后端将您与HuggingFace的LLM连接起来,以便它们可以在您的硬件上高效运行。这些模型中的许多可以通过文件类型进行识别llama.cpp后端,以便它们可以在您的硬件上高效运行。这些模型中的许多可以通过文件类型进行识别.gguf.

示例模型

许多LLM以不同的尺寸、量化和许可证可用。

-

参数更多的LLM通常在连贯地响应指令方面表现更好

-

量化较小的LLM(例如4位而不是16位)速度更快,内存占用更少,但性能略差

-

许可证在个人和商业用途的条款方面有所不同

以下是一些示例:

| 模型 | 文件大小 | 所需RAM | 参数 | 量化 | 开发者 | 许可证 | MD5总和(唯一哈希) |

|---|---|---|---|---|---|---|---|

| Llama 3 Instruct | 4.66 GB | 8 GB | 80亿 | q4_0 | Meta | Llama 3许可证 | c87ad09e1e4c8f9c35a5fcef52b6f1c9 |

| Nous Hermes 2 Mistral DPO | 4.11 GB | 8 GB | 70亿 | q4_0 | Mistral & Nous Research | Apache 2.0 | Coa5f6b4eabd3992da4d7fb7f020f921eb |

| Phi-3 Mini Instruct | 2.18 GB | 4 GB | 40亿 | q4_0 | Microsoft | MIT | f8347badde9bfc2efbe89124d78ddaf5 |

| Mini Orca(小) | 1.98 GB | 4 GB | 30亿 | q4_0 | Microsoft | CC-BY-NC-SA-4.0 | 0e769317b90ac30d6e09486d61fefa26 |

| GPT4All Snoozy | 7.37 GB | 16 GB | 130亿 | q4_0 | Nomic AI | GPL | 40388eb2f8d16bb5d08c96fdfaac6b2c |

搜索结果

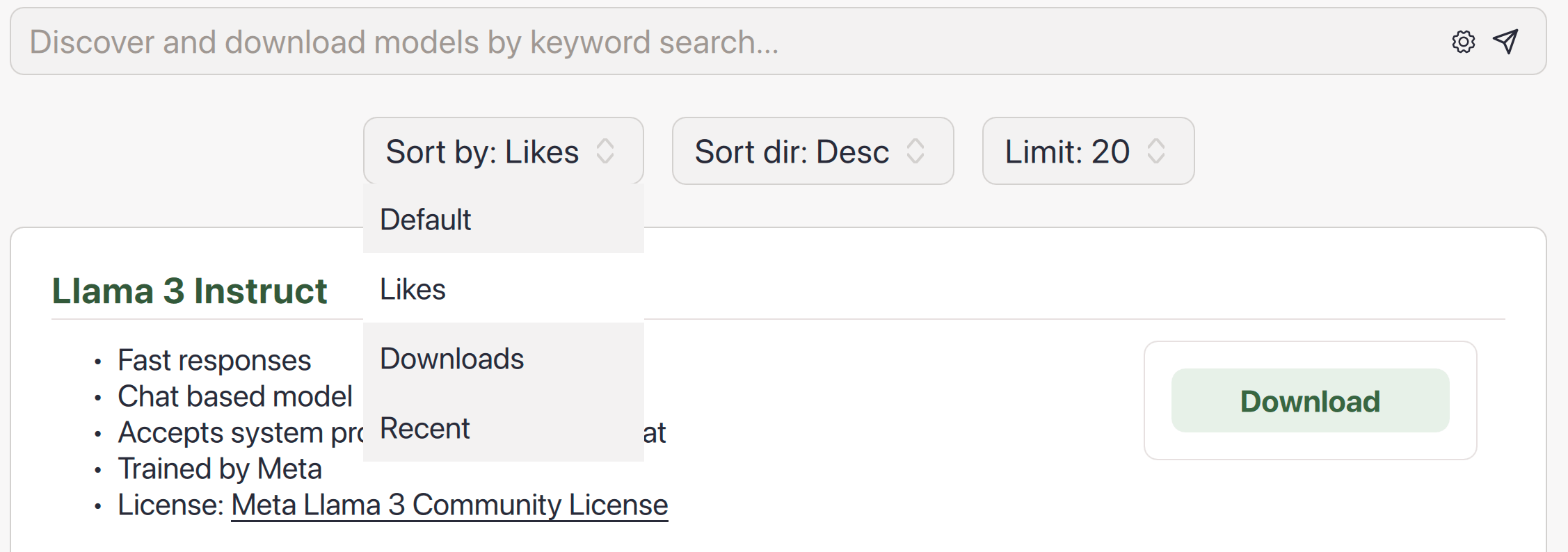

您可以点击搜索栏中的齿轮图标,按点赞数、下载次数或上传日期(均来自HuggingFace)对搜索结果进行排序。

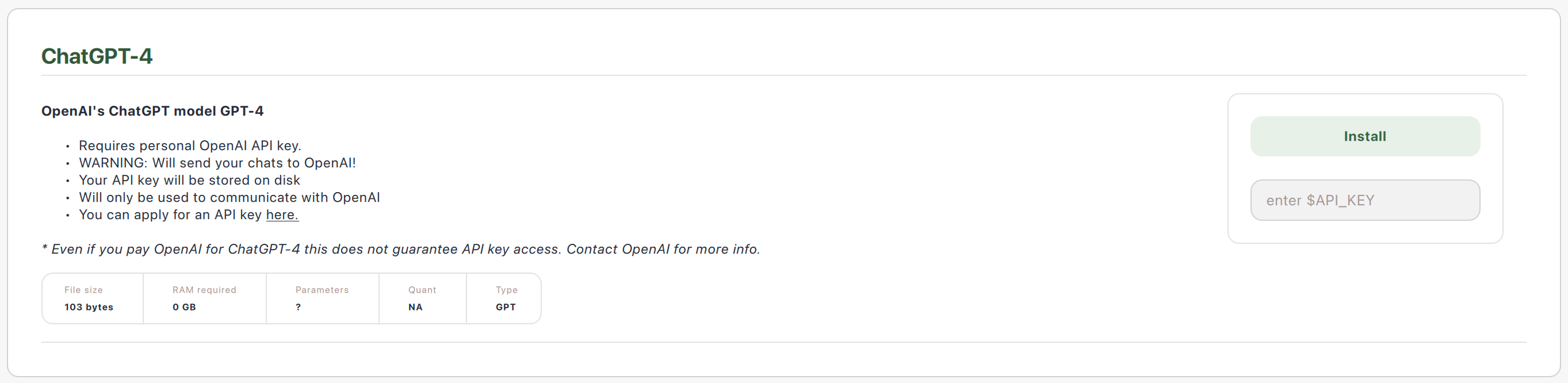

连接模型API

您可以添加远程模型提供者的API密钥。

注意: 这不会将模型文件下载到您的计算机上以安全使用。相反,这种与模型交互的方式使您的提示离开您的计算机,到达API提供者,并将响应返回到您的计算机。